VuFind® Berlin 2025: What’s in it for us?

Save the date! VuFind® Global Summit & German VuFind®-Anwendertreffen Berlin State Library (and online) Theme: What’s in it for us? September 29 – 30, 2025 Submissions welcome until July 01 until July 11 Please for questions. Call for Papers (de) Englisch version below Discovery-Systeme im Allgemeinen und speziell VuFind® spielen eine zentrale Rolle in den […]

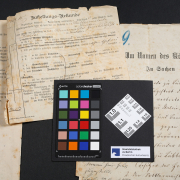

©Stabi Berlin 2025

©Stabi Berlin 2025 © ETH-Bildarchiv Zürich

© ETH-Bildarchiv Zürich