Kreuz und Que(e)r Exkurs: Korean Queer Movies

Ein Beitrag von Ida Strohe, Bibliothekarin für das Koreareferat, Ostasienabteilung der Staatsbibliothek. Koreanische Filme erfreuen sich mehr und mehr Beliebtheit auf der internationalen Bühne, sind aber schon lange im Fokus vieler Filmliebhaber. Und obwohl die koreanische Filmindustrie schon über 100 Jahre alt ist und viele herausragenden Filme hervorgebracht hat, waren Filme mit queerem Inhalt für […]

Staatsbibliothek zu Berlin – PK. Lizenz: CC-BY-NC-SA

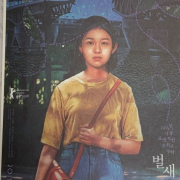

Staatsbibliothek zu Berlin – PK. Lizenz: CC-BY-NC-SA