Tagungsbericht zum Graduiertenworkshop „Schriftkulturen des Mittelalters in digitaler Perspektive” am 22. und 23. August 2025 an der Staatsbibliothek zu Berlin

Zuerst erschienen bei Mittelalter. Interdisziplinäre Forschung und Rezeptionsgeschichte (https://mittelalter.hypotheses.org/37473) unter der Lizenz CC BY-SA 3.0 Unported

Am 22. und 23. August 2025 fand an der Staatsbibliothek zu Berlin – Stiftung Preußischer Kulturbesitz – zum ersten Mal der Cross-NFDI-Graduiertenworkshop[1] „Schriftkulturen des Mittelalters in digitaler Perspektive“ statt. Im Vorfeld des Sommerkurses „Inschrift – Handschrift – Buchdruck. Medien der Schriftkultur im späten Mittelalter“ am Alfried Krupp Wissenschaftskolleg Greifswald in der darauffolgenden Woche (25.–29.8.2025) gestalteten Nicole Eichenberger (Staatsbibliothek Berlin), Andreas Janke (Staatsbibliothek Berlin) und Christoph Klose (Münzkabinett, Staatliche Museen zu Berlin) den Berliner Workshop für interessierte Studierende und Promovierende. Gefördert wurde er von den Konsortien 4Objects sowie 4Memory der Nationalen Forschungsdateninfrastruktur (NFDI). Der Schwerpunkt des Berliner Kurses lag auf den digitalen Aspekten der Arbeit mit historischen schrifttragenden Objekten, die in fünf Themenblöcken, zwei Hands-on-Sessions und einer öffentlichen Podiumsdiskussion diskutiert und ausprobiert wurden.

Themenblock I: Codierung und maschinelle Verarbeitung von Texten

Im ersten Themenblock vermittelten Nicole Eichenberger und Roman Kuhn (Staatsbibliothek Berlin) zunächst Grundlegendes zu Aufbau und Modellierung von XML, einer Auszeichnungssprache zur Strukturierung von Textdateien. Dies bildete die Basis für die sich anschließende Auseinandersetzung mit TEI (Text Encoding Initiative), welches auf der Basis von XML zur Kodierung von Texten dient und damit wiederum Grundlage von Editionen sein kann. TEI umfasst umfangreiche Guidelines mit einem standardisierten Regelwerk und Vokabular und erleichtert so die Nutzung.[2] Besonders das Modul MsDesc, mit dem Handschriftenbeschreibungen erstellt werden können, interessierte im Folgenden. Verschiedene Komponenten des Moduls wurden vorgestellt und deren Anwendung praxisnah demonstriert. Anschließend erhielten die Teilnehmenden eine kurze Einführung in den XML-Editor Oxygen, der den Vorteil bietet, das TEI-Schema bereits integriert zu haben, bevor sie in einem praktischen Teil Daten aus einem gedruckten Handschriftenkatalog in TEI kodierten.

Abb. 1: Roman Kuhn veranschaulicht die Modellierung von XML, Lizenz: CC BY-NC-SA.

Themenblock II: Digitale Plattformen für die Arbeit mit schriftlichem Kulturgut

Der anschließende Themenblock setzte sich aus drei Kurzvorträgen und praktischen Übungen zusammen. Den Auftakt gestaltete Robert Giel (Staatsbibliothek Berlin), der das Handschriftenportal (https://handschriftenportal.de) vorstellte, welches neben Beschreibungen auch Digitalisate und Metadaten zu (nicht nur mittelalterlichen) Handschriften in deutschen Sammlungen bündelt und zugänglich macht. Jede Handschrift ist dort als Kulturobjektdokument mit eigenem, persistentem Identifier registriert, ergänzt durch feste URIs und über IIIF bereitgestellte Bildmetadaten. Giel verdeutlichte, inwiefern TEI die Grundlage der Arbeit im Backend des Handschriftenportals bildet. Abschließend skizzierte er Entwicklungsperspektiven für das Portal, darunter die Ausweitung von Verfahren zur Handwritten Text Recognition (HTR) und Volltextintegration sowie die Möglichkeit, eigene Annotationen zu speichern und zu veröffentlichen. In der anschließenden Übung führten die Teilnehmende Rechercheaufträge im Handschriftenportal durch und erprobten dessen Funktionen praktisch.

Im zweiten Kurzvortrag stellten Katharina Kagerer (Niedersächsische Akademie der Wissenschaften zu Göttingen) und Jakob Jünger (Universität Münster / Akademie der Wissenschaften und der Literatur Mainz) die Datenbank Deutsche Inschriften Online (DIO) (https://www.inschriften.net/) vor. Da sich der Begriff „Inschriften“ ganz allgemein auf Texte auf dauerhaften Materialien bezieht – einschließlich gemalter Schriftzüge –, versammelt die Datenbank eine große Vielfalt an erfassten Objekten. Ergänzend dazu steht die Plattform Epigraf (epigraf.inschriften.net) zur Verfügung, die strukturierte Forschungsdaten bereitstellt und für weiterführende Analysen nutzbar macht. Im praktischen Teil konnten die Teilnehmenden eigenständig im Portal recherchieren und die Funktionalitäten erproben. Als Beispiel dienten Glocken, denen die apotropäische Funktion zugeschrieben wurde, Unwetter mit ihrem Geläut zu vertreiben, was immer wieder auch in Glockeninschriften thematisiert wurde.[3] Den Abschluss des Themenblocks bildete der Vortrag von Christoph Klose, der den interaktiven Katalog ikmk.net des Münzkabinetts der Staatlichen Museen zu Berlin vorstellte. Dieser Katalog ist Teil eines internationalen Portals, in dem sich mittlerweile über fünfzig Sammlungen zusammengeschlossen haben, darunter auch Institutionen in Wien und Athen. Im Vortrag wurden sowohl Frontend als auch Backend des Systems präsentiert, ehe die Teilnehmenden im praktischen Übungsteil eigene Rechercheaufgaben durchführten.

Podiumsdiskussion

Die abendliche Veranstaltung war öffentlich und wurde von Carolin Schreiber (Bayerische Staatsbibliothek München) moderiert. Auf dem Podium diskutierten neben ihr Frederike Neuber (Berlin-Brandenburgische Akademie der Wissenschaften), Carmen Stange (Humboldt-Universität zu Berlin) und Jakob Jünger zunächst ausgehend von der Frage, inwiefern mittelalterliche Schriftobjekte unter besonderer Berücksichtigung ihrer Materialität und unterschiedlicher methodischer Zugänge erforscht werden können. Die digitale Transformation spiele hier eine immer bedeutendere Rolle, etwa in der Editionsarbeit, wo sich kollaboratives Arbeiten etabliert habe und Verfahren wie maschinelles Lernen mittlerweile in nahezu jedem Projektantrag präsent seien, wie Frederike Neuber betonte. Jakob Jünger knüpfte hieran an und verwies auf den Einsatz von Forschungssoftware wie der zuvor vorgestellten Epigraf, die strukturierte Forschungsdaten erzeugt. Carmen Stange berichtete aus der Hochschullehre und inwiefern dort die über digitale Portale bereitgestellten Ressourcen wie Digitalisate von Handschriften die Lehre inhaltlich bereichern würden. Carolin Schreiber brachte auch die Perspektive der Bibliotheken ein, wo digitale Infrastrukturen gänzlich neue Methoden eröffnen, etwa im Bereich der HTR. Spezifische Sprach- und Schriftkenntnisse könnten dadurch einerseits an Bedeutung verlieren, andererseits würden Manuskripte so aber auch zugänglicher. Letzteres sei insbesondere für die Hochschullehre wichtig. Stange berichtete, dass hier durch die Verwendung digitaler Medien die Auseinandersetzung mit dem Original nicht wie befürchtet immer mehr ins Hintertreffen gerate; im Gegenteil, das Interesse am Materiellen nehme unter den Studierenden wieder zu.

Diskutiert wurden auch die Kompetenzen, die künftig erforderlich sind, um die digitalen Methoden sinnvoll nutzen zu können. Da entsprechende Inhalte im Studium häufig nicht systematisch vermittelt würden, müssten sich interessierte Studierende digitale Fähigkeiten oft autodidaktisch aneignen. In Zukunft müssten digitale Methoden noch besser in die Lehre integriert werden: Der unreflektierte Einsatz von Anwendungen wie ChatGPT etwa verdeutlicht die Notwendigkeit einer fundierten „AI Literacy“ (analog zur bereits etablierten „Data Literacy“). So könne generative KI zwar viele Arbeiten erleichtern, gleichzeitig sei es für die Qualitätskontrolle unverzichtbar, die Ergebnisse kritisch überprüfen und bewerten zu können. Digitale Werkzeuge veränderten somit vor allem die Arbeitsvorgänge, nicht aber die Verantwortung der Forschenden.

Abb. 2: Auf dem Podium diskutieren Carmen Stange, Carolin Schreiber, Jakob Jünger und Frederike Neuber, Lizenz: CC BY-NC-SA.

Ein weiterer Themenschwerpunkt der Diskussion widmete sich der Materialanalytik und dem Einsatz naturwissenschaftlicher Methoden in den Geisteswissenschaften, wie sie in auch forschenden Bibliotheken bereits zunehmend genutzt werden. Noch offen ist in vielen Fällen der Umgang mit den dabei entstehenden Forschungsdaten, etwa bei Fragen der Langzeitarchivierung. Auch liegen in den Naturwissenschaften Forschungsdaten häufig in proprietären Formaten vor, was bei Projekten mit Förderung aus öffentlichen Mitteln problematisch ist. Diskutiert wurde auch, welche Arten von Forschungsdaten überhaupt anfallen; ob etwa nur die publizierten Daten als Forschungsdaten zu betrachten sind oder auch alle Zwischenschritte auf dem Weg dorthin.

Abschließend rückten noch einmal die Risiken und Fallstricke der Digitalisierung in den Fokus. Die zunehmenden Mensch-Maschine-Interaktionen treiben die Forschung zwar voran, erfordern aber auch eine wissenschaftshistorische Neubewertung. Es müsse stärker dokumentiert werden, wie aktuelle Forschungsprozesse verlaufen, da sich Entwicklungen immer weiter beschleunigen.

Themenblock III: KI und historische Dokumente

Nicole Eichenberger und Roman Kuhn referierten im dritten Block am Samstagvormittag zu unterschiedlichen Aspekten der automatischen Text- und Bilderkennung. Insbesondere im Bereich der Handschriftenerkennung vollziehen sich weiterhin große Fortschritte, auch wenn unterschiedliche Handschriften nach wie vor aufwendige Nachkorrekturen erfordern. Im Folgenden stand vor allem die Open-Source-Plattform eScriptorium (https://ocr-bw.bib.uni-mannheim.de/escriptorium/) im Fokus, da sie gegenüber proprietären Angeboten wie Transkribus (https://www.transkribus.org/) eine Vielzahl an Vorteilen bietet. Etwa lassen sich IIIF-Manifeste verarbeiten und kollaboratives Arbeiten ist einfacher möglich. Abschließend wurde auch die wichtige Frage der Evaluation angesprochen und gezeigt, mit welchen Methoden die Qualität der Texterkennung möglichst zuverlässig gemessen werden kann. Roman Kuhn stellte als Beispiel einer Arbeit mit eScriptorium das Projekt Fanny loves Wilhelm vor, ein Transkriptionsvorhaben, das in Kooperation mit der Universität der Künste durchgeführt wurde.[4] Die kurzen Billets, die Kuhn als „SMS des 19. Jahrhunderts“ bezeichnete, waren zuvor nicht ediert und daher kaum auffindbar. Daran anschließend ging er auf die Möglichkeiten der automatische Bilderkennung und Bildähnlichkeitssuche ein, die an der Staatsbibliothek Berlin im Zuge der Layouterkennung bei der Digitalisierung von Zeitschriften immer weiterentwickelt wurde.

Abb. 3: Nicole Eichenberger stellt HTR vor, Lizenz: CC BY-NC-SA.

Themenblock IV: Materialanalyse und bildgebende Verfahren

Eingeleitet wurde der vierte Themenblock von Andreas Janke, der darauf verwies, dass materialanalytische Verfahren auch in Bibliotheken eine immer größere Rolle spielen und auch vonseiten Forschender vermehrt angefragt würden. Die multispektrale Bildgebung (MSI) ist hier die erste Wahl, da das Verfahren zerstörungsfrei ist und vergleichsweise unkompliziert eingesetzt werden kann. Sie basiert auf der unterschiedlichen Reaktion bestimmter Materialien auf verschiedene Lichtwellen. Janke stellte sowohl die technischen Voraussetzungen als auch die mit den Analysen einhergehenden Datenflüsse vor; materialanalytische Verfahren führen zu einer enormen Datenmenge und machen ein effizientes Forschungsdatenmanagement unerlässlich.

Ira Rabin (Bundesanstalt für Materialforschung, Berlin) verdeutlichte anschließend die Tintencharakterisierung durch optische Analysemethoden. Sie stellte zunächst den Unterschied zwischen Tusche und Tinte heraus: Während Tusche aus Ruß besteht, unlöslich ist und lediglich auf der Oberfläche haftet, handelt es sich bei Tinten, wie der Eisengallustinte, um Lösungen, die in das Trägermaterial eindringen. Diese Unterschiede spiegeln sich auch in den optischen Eigenschaften der beiden Schreibstoffe: Rußtusche zeigt im Infrarot- und UV-Bereich stets das gleiche Verhalten, während Eisengallustinte bei bestimmten Wellenlängen im Infrarotbereich unsichtbar wird. Als präzisere, wenn auch deutlich aufwendigere Methode wurde die Röntgenfluoreszenzanalyse (RFA) vorgestellt. Dieses Verfahren erlaubt Rückschlüsse auf die elementare Zusammensetzung, auch wenn bei dünnen Schichten nur die Hauptkomponenten zuverlässig bestimmt werden können. Aus den Messungen ergibt sich ein charakteristischer „Tintenfingerprint“, bei dem die Anteile anderer Elemente in Relation zu Eisen gesetzt werden. Rabin verwies jedoch auch auf Fallstricke: So muss bei Messungen berücksichtigt werden, ob die Rückseite des Pergaments oder Papiers ebenfalls beschrieben ist, da dies die Ergebnisse verfälschen kann.

Hands-on!

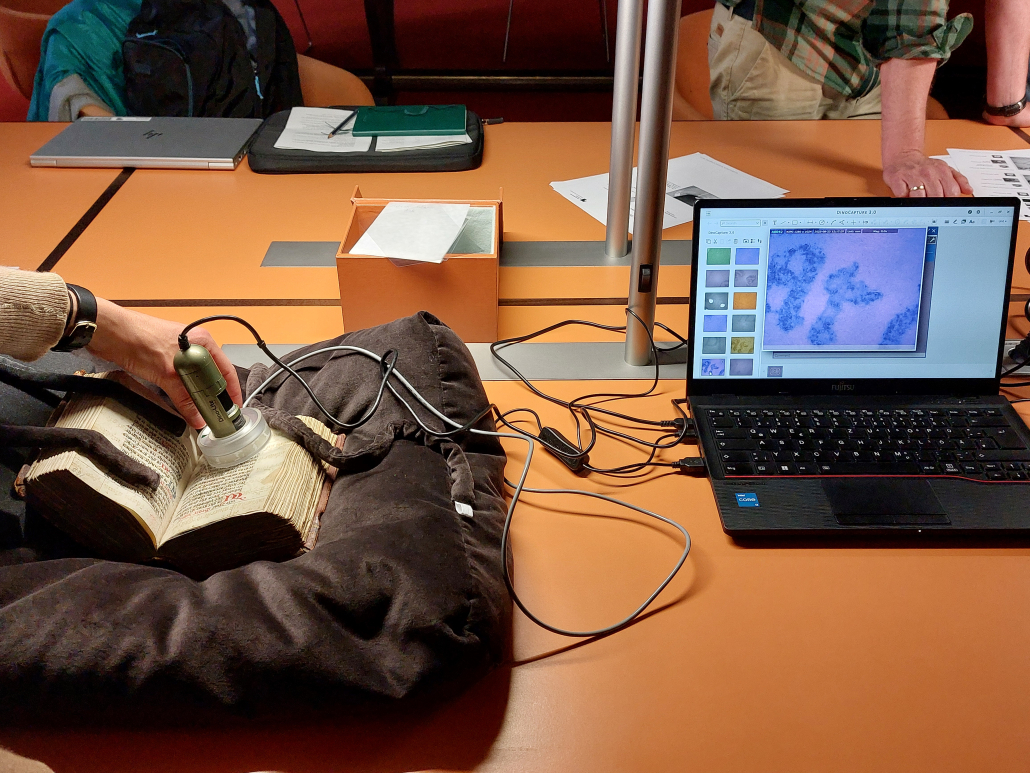

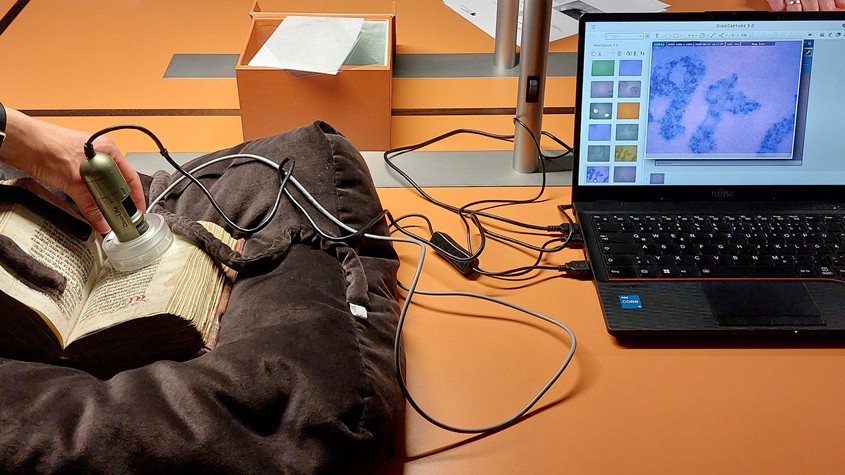

An die Themenblöcke III und IV schlossen sich praktische Sessions an, in denen die Teilnehmenden in zwei Gruppen aufgeteilt wurden: Während die eine Gruppe Handschriften mithilfe von Dino-Lites im UV- und IR-Bereich untersuchte, arbeitete die andere mit dem Transkriptionstool eScriptorium. Im Rahmen des Hands-on-Workshops zum Dino-Lite führte Andreas Janke zunächst in die Funktionsweise des Geräts ein und erläuterte den praktischen Umgang. Die per USB einfach zu handhabenden und portablen Digitalmikroskope erlauben eine niedrigschwellige Untersuchung von Trägermaterialien, Schreib- und Farbstoffen. Anschließend konnten die Teilnehmenden das Instrument zunächst an vorbereiteten Proben, später auch an mittelalterlichen Handschriften erproben. Im gemeinsamen Austausch wurden Fragen etwa danach diskutiert, welche Tinten verwendet wurden. Wo lassen sich Palimpseste identifizieren? Wo liegen die Grenzen der Technik, und wann ist der Einsatz von Röntgenfluoreszenzanalyse (RFA) erforderlich? Parallel dazu leitete Nicole Eichenberger eine Transkriptionssession. Die Teilnehmenden luden hierfür IIIF-Daten aus den digitalisierten Sammlungen der Staatsbibliothek auf eScriptorium und übten das automatisierte Segmentieren und Transkribieren.

Abb. 4: Teilnehmende arbeiten unter Anleitung von Andreas Janke mit dem Dino-Lite, Lizenz: CC BY-NC-SA.

Abb. 5: Das Dino-Lite im Einsatz, Lizenz: CC BY-NC-SA.

Themenblock V: Forschungsdatenmanagement

Der letzte Themenblock setzte mit einer Diskussion darüber ein, was unter Forschungsdaten überhaupt zu verstehen sei. In einer Gruppenarbeit wurde pro Gruppe je ein Forschungsdatensatz auf die FAIR-Kriterien[5] hin untersucht und überlegt, um welche Art von Daten es sich handelt, wie diese dokumentiert sind und ob Hilfestellungen für die Nachnutzung vorliegen. Daran anschließend stellte Christoph Klose in einem Kurzvortrag zentrale Aspekte des Forschungsdatenmanagements vor, darunter Anlaufstellen, Richtlinien und praktische Hilfsmittel, die Forschende bei der Erstellung von Datenmanagementplänen unterstützen können.[6] Darüber hinaus führte er in das NFDI-Netzwerk ein und erläuterte dessen Ziel, das Forschungsdatenmanagement auf nationaler Ebene stärker zu bündeln und nachhaltig zu verankern.

Fazit

Der Workshop machte an einer Vielzahl an Themen deutlich, wie stark digitale Methoden und Infrastrukturen die geisteswissenschaftliche Forschung zum mittelalterlichen Schrift- und Kulturgut bereits prägen, aber auch, welche Herausforderungen noch bestehen. Besonderes Anliegen der beiden Tage war eine enge Verzahnung von Theorie und Praxis. Dabei sollten Lücken, die in der universitären Lehre immer noch bestehen, geschlossen und zentrale Kompetenzen in den Digital Humanities vermittelt werden. Deutlich wurde, dass Fragen des Forschungsdatenmanagements, der Nachhaltigkeit und Nachnutzbarkeit von Daten sowie die Rolle von Open-Source-Lösungen für die künftige Forschung von zentraler Bedeutung sind. Wünschenswert wäre daher, dass Formate wie dieser Workshop auch langfristig in regelmäßigen Abständen – etwa weiterhin ergänzend zum Greifswalder Kurs – stattfinden und so Studierenden wie Promovierenden einen Zugang zu diesen Methoden ermöglichen.

Links zu den Veranstaltungen

https://blog.sbb.berlin/termin/mittelalterliche-schriftkulturen-in-digitaler-perspektive/

https://blog.sbb.berlin/termin/podium-schriftkulturen-des-mittelalters-in-digitaler-perspektive/

Alle Fotografien von Judith Utz. Alle angegebenen Links wurden am 13. November 2025 geprüft.

[1] NFDI steht für Nationale Forschungsdateninfrastruktur und ist ein konsortiales Netzwerk, das sich dafür einsetzt, Forschungsdaten für die Wissenschaft zu erschließen, zu sichern und zugänglich zu machen, www.nfdi.de.

[2] The TEI Guidelines.

[3] Etwa wie im Falle einer 1493 gegossenen Glocke, vgl. Deutsche Inschriften Online, Suchergebnis für den Begriff „Hagel“, https://tinyurl.com/bdz6sdvv.

[4] https://zenodo.org/records/15223355.

[5] FAIR steht für findable (auffindbar), accessible (zugänglich), interoperable (interoperabel) und reusable (wiederverwendbar), GO FAIR initiative: Make your data & services FAIR, https://www.go-fair.org/.

[6] Die DFG bietet einen Überblick über den angemessenen Umgang mit Forschungsdaten (DFG – Deutsche Forschungsgemeinschaft – Umgang mit Forschungsdaten), die RWTH Aachen zum Beispiel stellt ein Tool vor, mit dem sich Datenmanagementpläne (DMP) erstellen lassen (Zentrale FDM-Services an der RWTH: RDMO – Forschungsdaten – Aktuelles und Wissenswertes).

Wissenswerkstatt Schulung SBB-PK CC BY-NC-SA 3.0

Wissenswerkstatt Schulung SBB-PK CC BY-NC-SA 3.0

SBB-PK CC BY-NC-SA 3.0 (erstellt: C. Murawski Verzicht auf Namensnennung)

SBB-PK CC BY-NC-SA 3.0 (erstellt: C. Murawski Verzicht auf Namensnennung)

Ihr Kommentar

An Diskussion beteiligen?Hinterlassen Sie uns einen Kommentar!