Wie künstlich intelligent ist Computerlinguistik?

Ein Beitrag aus unserer Reihe Künstliche Intelligenz zum Wissenschaftsjahr 2019

Angesichts der nahe liegenden Assoziation Computer + Sprache = Computerlinguistik könnte die Frage aufkommen, womit sich in Abgrenzung dazu die Künstliche Intelligenz (KI) befasst, wenn sie sich mit Sprache befasst. Beleuchten wir, wie im ersten Beitrag unserer Blogreihe angekündigt, das Verhältnis beider Disziplinen zueinander, und wenden uns zunächst der Computerlinguistik zu.

Die Bezeichnung Computerlinguistik nimmt ihren Anfang 1963 mit dem englischen „Computational Linguistics“ im Fachverbandsnamen „Association for Machine Translation and Computational Linguistics“ in den USA. Sie ist damit jünger als „Artificial Intelligence“, kommt deren sprachlicher Ausrichtung aber zuvor. Die Disziplin entstand allerdings nicht aus dem Nichts.

In den 30er und 40er Jahren des 20. Jahrhunderts beschäftigte sich die junge Computertechnologie vor allem mit Zahlen und rechnerischen Problemen. Entsprechend wurden Begriffe wie „Elektronenrechner“, „Rechentechnik“ geprägt. (Heute würde – zumindest aus Anwendersicht – eine Bezeichnung wie das finnische Wort für Computer „tietokone“ = „Wissensmaschine“ durchaus motivierter erscheinen.) Doch schon beim Dechiffrieren verschlüsselter Nachrichten im Zweiten Weltkrieg ließen sich Computer nutzbringend einsetzen und zeigten dabei ihr Potential auch für die Verarbeitung von Texten. 1949 dann gab es in der Informationstheorie den Versuch, mit Hilfe von statistischen Wahrscheinlichkeiten Sprache präziser zu erfassen. In den 50er Jahren wurde die Maschinelle Sprachübersetzung zu der zentralen Zielstellung für sprachlichen Computereinsatz, anfangs gesehen als Decodierungsaufgabe in Weiterentwicklung der Nachrichtendechiffrierung, derer man mit sprachstatistischen Indikatoren und berechneten Übergangswahrscheinlichkeiten Herr zu werden hoffte – was misslang. Weder die semantische Seite fand Berücksichtigung, noch wurden philologische Sprachanalysen einbezogen. Von Methodik, Kenntnissen, fachlicher Ausrichtung und Selbstverständnis der Akteure hatten diese Programme viel mit Computer, doch noch relativ wenig mit Linguistik zu tun.

Mitte der 60er Jahre rückte angesichts ausbleibender Erfolge die linguistische Grundlagenforschung beim Computereinsatz für sprachliche Anwendungen als notwendig ins Blickfeld. Die Computerlinguistik wurde als wissenschaftliche Disziplin innerhalb der Linguistik etabliert, um sich, gestützt vorrangig auf linguistische Theorien, mit Fragen zu befassen, die sich aus der Nutzung von Computern bei der Verarbeitung natürlichsprachlich formulierter Information ergeben. Die primäre Fokussierung auf Probleme der Maschinellen Übersetzung blieb zunächst beibehalten, wie sich am Fachverbandsnamen von 1963 „Association for Machine Translation and Computational Linguistics“ ablesen lässt, der oben im Text zunächst überrascht haben mag. Die Umbenennung 1968 in „Association for Computational Linguistics“ (so heißt sie noch heute und nennt sich kurz ACL) spiegelt die Öffnung für weitere Fragestellungen wider. Drei Anwendungstypen nennt das Handbuch Computational Linguistics, anhand derer sich die Computerlinguistik maßgeblich profilierte: maschinelle Übersetzung – mit dem Fokus auf Syntax; Information Retrieval – für Sprachinhalte; Frage- und Antwortsysteme – für Aspekte der Kommunikation. Linguistische Grundlagenforschung sollte jedes dieser Gebiete getrennt bedienen und darüber hinaus verallgemeinerte, abstraktere Erkenntnisse beisteuern. Alle drei finden aber auch das Interesse der Künstlichen Intelligenz als sprachliche Anwendungen im Kontext der Mensch-Maschine-Interaktion. Ist Computerlinguistik also Teil der KI, oder macht sie ihr Konkurrenz?

Computerlinguistik sind heute zum einen sprachwissenschaftliche Forschungen, die auf den Einsatz von Computern zur Verarbeitung sprachlichen Materials ausgerichtet sind, um Phänomene, Strukturen und Prozesse natürlicher Sprache zu beschreiben, zu analysieren und nachbilden zu können, zum anderen gehören hierzu linguistische Untersuchungen mit dem Computer als leitender Modellvorstellung.

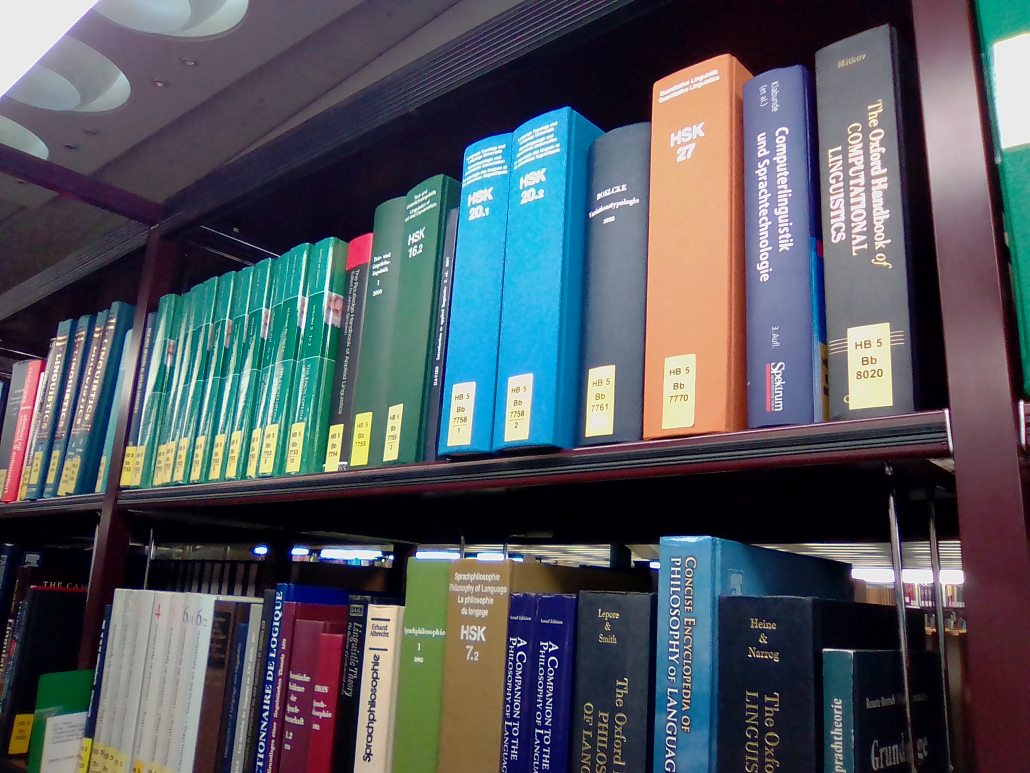

Während also folgerichtig die Computerlinguistik einen Zweig der Linguistik darstellt, der interdisziplinär mit der Informatik verbunden ist, wird KI als Teilgebiet der Informatik mit starken interdisziplinären Bezügen zur Kognitionswissenschaft (wiederum mit der kognitiven Linguistik als einem Teilgebiet) eingeordnet. Man ahnt, dass es viele Überschneidungen und unklare Abgrenzungen gibt, zumal beide grundsätzlich interdisziplinär ausgerichtet sind. Die fachliche Eingliederung spielt für praktische Anwendungsergebnisse natürlich keine Rolle. Sie ist vor allem eine Sache der institutionellen Anbindung, Wissenschaftsorganisation – und für den Platz in unseren Lesesälen entscheidend: Nachschlagewerke zur Künstlichen Intelligenz als Teil der Informatik stehen in der HB 12, Computerlinguistik findet innerhalb der Sprachwissenschaft in HA 5 und HB 5 Berücksichtigung. Zum Glück bietet die Referenzliteratur Informationen auch zum jeweils anderen Fach.

Wie groß die Berührungspunkte und Überschneidungen beider Disziplinen tatsächlich sind, ist stark abhängig davon, was man unter Computerlinguistik versteht. Ja allein die Frage, ob jede Rechneranwendung auf Sprache gleich Computerlinguistik ist, lässt sich weniger eindeutig beantworten, als man meint. In einer sehr weit gefassten Definition können nämlich beinahe alle Kombinationsmöglichkeiten zwischen natürlichen Sprachen und Computern hier subsumiert werden. Daneben bestehen recht unterschiedliche Auffassungen von ihrem Gegenstandsbereich:

Das Spektrum reicht von der praxisorientierten Sicht als Sprachtechnologie mit der Entwicklung von Sprachsoftware bis zum Verständnis als theoriegeleitete Teildisziplin der Linguistik, die sich mit prinzipiellen Fragen der Sprachverarbeitung und berechnungsrelevanten Aspekten von Sprache befasst (zum Beispiel Grammatikformalismen), unabhängig von einer tatsächlichen Computeranwendung. Dazwischen liegt die Linguistische Datenverarbeitung, das heißt die Verarbeitung von Sprachdaten (heute typischerweise in Sprachkorpora) mit speziell entwickelten Computerprogrammen. Und schließlich – hier wird es wieder für unser Thema interessant – die Realisierung natürlichsprachlicher Phänomene auf dem Computer, das sogenannte Natural Language Processing (NLP, maschinelle Sprachverarbeitung). Diese ist undenkbar ohne sprachorientierte formale Logik und sprachphilosophische Untersuchungen. Sie schließt die Behandlung von Sprache als Teil des kognitiven Systems ein, da sprachliche Kenntnisse eng verknüpft sind mit nicht-sprachlichem Wissen, Denkprozessen und Handlungsplanungen. In diesem Sinne besteht ein unmittelbarer Zusammenhang mit der Kognitionswissenschaft – und mit der KI.

In der Erwerbungspraxis der Staatsbibliothek wird die Computerlinguistik als theoretische und Grundlagenwissenschaft in breiter bis sehr breiter Auswahl auf Forschungsstufe innerhalb der Allgemeinen Sprachwissenschaft berücksichtigt; je stärker die Ausrichtung auf Sprachtechnologie, desto zurückhaltender wird ausgewählt.

Sprachverarbeitungsaufgaben, bei denen eine (relativ) zufriedenstellende Lösung bereits auf der Basis von Formalaspekten möglich ist und die nur einen sehr schwachen Bezug zur Semantik aufweisen, mögen – je nach Auffassung – zur Computerlinguistik gerechnet werden oder nicht, sind aber auf keinen Fall KI-relevant.

Hierzu gehören spielerische Anwendungen wie Anagrammgeneratoren, wichtige wie automatische Silbentrennung, nützliche wie Rechtschreibprüfung und -korrektur, ja auch das Erstellen von Konkordanzen, Lemmatisierung und einfache Ansätze zur syntaxbasierten Maschinellen Übersetzung. Genauso wenig mit KI zu tun haben rein linguistische Untersuchungen wie beispielsweise zu den Gesetzten des Lautwandels oder der Dialektgeographie sowie das Testen von Grammatikmodellen, die aber unbestritten wichtige Anwendungen der Computerlinguistik sind.

Sprachorientierte KI tritt auf den Plan, wenn eine explizite Beschäftigung mit der Bedeutung sprachlicher Ausdrücke unverzichtbar ist, und wo für Sprachverstehen und Sprachproduktion konzeptuelle Strukturen erforderlich sind. Anwendungen sind Maschinelle Übersetzung, Frage-Antwort-Systeme, Informationserschließungssysteme, automatische Textzusammenfassung – die alle auch im Fokus der Computerlinguistik stehen.

Rivalisierend arbeiten beide Disziplinen dabei nicht, sondern – bei unterschiedlichen Forschungszielen – eher komplementär zueinander. Die Computerlinguistik analysiert die innersprachlichen Mechanismen. Für die Sprachverarbeitung liefert sie Grundlagen wie morphologische Analyse, Syntaxparsing oder semantische Interpretation, die als Komponenten in Sprachverstehenssystemen genutzt werden. Unabhängig von einer praktischen Anwendung geht es ihr jedoch darum, linguistische Erkenntnisse zu systematisieren und zu verallgemeinern, wozu auch die sprachliche Abbildung kognitiver Vorgänge gehört. Für die KI dagegen sind kognitive Zusammenhänge und Repräsentationen zentral, Sprachkomponenten und natürlichsprachlicher Ausdruck eher nebensächlich. In der Sprachverarbeitung geht es ihr um Fragen wie eine individualisierte Modellierung nach Zielen, Vorkenntnissen und Wertungen einzelner Sprachverwender, die eine nutzeradaptive Aufbereitung von Informationen möglich macht oder auch Verbesserungen in Dialogsystemen verspricht.

Über aktuelle Forschungsfragen der Computerlinguistik kann man sich gut informieren in der Zeitschrift Computational linguistics, dem Publikationsorgan der ACL.

Zur Orientierung über Themenfelder und aktuelle Entwicklungen zu empfehlen ist auch die Homepage der „Gesellschaft für Sprachtechnologie und Computerlinguistik“ (GSCL, „German Society for Computational Linguistics and Language Technology„; raffiniert, den englischen Namen gegenüber dem deutschen so zu modifizieren – oder war es umgekehrt? -, dass die Abkürzung für beide passt), die unter anderem mit der ACL kooperiert.

Als zentrale Zeitschrift der KI ist Artificial Intelligence zu nennen. Ein Überblick über die dort behandelten Themen zeigt, dass sprachliche Fragen nur einen kleinen Teil ausmachen, aber regelmäßig vertreten sind. Beispielhaft sei zum Schluss ein Beitrag herausgegriffen, der typische Forschungsfragen der KI illustriert:

Der Aufsatz „Choosing words in computer-generated weather forecasts“ von E. Reiter et al. (2005, Heft 167,1) stellt eine Anwendung von Textproduktion aus nicht-sprachlichen Input-Daten (Natural Language Generation, NLG) vor. Im Artikel geht es jedoch weniger um den produzierten Text selbst – der computergenerierte Wetterbericht ist bereits im Echtbetrieb erfolgreich im Einsatz -, als vielmehr um die Erstellung der Regeln für die Wortwahl (data-word-mapping) und umfassende Evaluation.

Für die Wortwahl wurde ein Korpus der bislang verfassten Wetterberichte analysiert. Dabei fiel auf, dass der Sprachgebrauch der einzelnen Meteorologen individuell variiert: Dieselben Daten (zum Beispiel Uhrzeiten) wurden mit unterschiedlichen Wörtern wiedergegeben und, gravierender noch, dieselben Wörter stehen zuweilen für verschiedene Werte. Um die gebotene Konsistenz zu erreichen, mussten selten gebrauchte und missverständliche Wörter eliminiert werden. Erstmals wurde der automatisch generierte Text positiver bewertet als ein von Menschen geschriebener – besser lesbar und besser verständlich. Zusätzlich wurde der tatsächliche Informationsgewinn überprüft, da subjektiv bevorzugte Darstellungen nicht unbedingt besser verstanden werden.

Aus der Erkenntnis, dass der individuelle Sprachgebrauch sehr unterschiedlich ist, werden weitere Anwendungsmöglichkeiten abgeleitet. Nach Studium einzelner solcher Idiolekte wäre es möglich, per Computer Texte zu generieren, die speziell auf die Empfänger zugeschnitten sind. Das wäre vorteilhaft etwa bei Informationen zu medizinischen Behandlungen, die für die Patienten verständlich sein sollten, es aber oft nicht sind. Nachdem das methodische Vorgehen klar ist, bleibt als Forschungsthema die Frage, wie man die Grundlagen für individuelle Idiolekt-Modelle bekommt. Nicht zuletzt werden dabei auch rechtliche Aspekte zu beachten sein.

Schließlich werden mit der Frage, welche Rolle idiolektale Differenzen in direkten Gesprächen spielen, erkenntnisorientierte Untersuchungen ohne direkten Anwendungsbezug angeregt.

Was der Artikel nicht thematisiert: In gleicher Weise wie für diesen Wetterbericht lassen sich Texte in verschiedenen Sprachen parallel direkt aus Messwerten oder anderem Zahlenmaterial generieren – eine attraktive Alternative zu Übersetzungen. Voraussetzung: Für die Zielsprache lässt sich ein ausreichend großes Korpus relevanter Texte zusammenstellen, auf dessen Grundlage die Generierungsregeln erstellt werden können.

Ebenso wie numerische Messwerte verbal umgesetzt werden können, lassen sich auch aus Bildern Texte generieren. Darüber, wieviel Optical Character Recognition damit zu tun hat, gibt der nächste Beitrag unserer Blogreihe Aufschluss, in dem es darum geht, wie mit Hilfe von KI aus gescannten Buchstaben mittels OCR digitale Texte werden.

Susanne Henschel

Susanne Henschel

Public Domain

Public Domain

Susanne Henschel

Susanne Henschel

Ich moechte wissen ,welche Beziehungen zwischen Computerlinguistik u. Digital Humanities bestehen. Wenn es bei Ihnen irgenwelcher Literaturhinweis oder Forschungsarbeit darueber vorhanden ist , senden Sie bitte diese moeglichst zu mir .Herzlichen Dank im voraus .

Sehr geehrter Herr Tadros,

Digital Humanities haben sich in den letzten Jahren als interdisziplinär ausgerichtetes Fach herausgebildet, das sich mit der Anwendung von computergestützten Verfahren und der systematischen Verwendung von digitalen Ressourcen in den Geistes- und Kulturwissenschaften befasst. Davon ausgehend, dass eine dieser Disziplinen die Computerlinguistik ist, können (prinzipiell) alle Arbeiten zu Digital Humanities auf die Computerlinguistik eingehen. Suchen Sie im StaBiKat nach dem Schlagwort „digital humanities“.

2 besonders relevante elektronische Titel seien genannt:

– Reflektierte algorithmische Textanalyse : interdisziplinäre(s) Arbeiten in der CRETA-Werkstatt (De Gruyter, 2020)

– Routledge international handbook of research methods in digital humanities (Routledge, 2021)

Mit freundlichen Grüßen,

Susanne Henschel