Der autonome Militärroboter

Ein Beitrag aus unserer Reihe Künstliche Intelligenz zum Wissenschaftsjahr 2019

Der autonome Militärroboter – Science fiction oder die Realität von morgen?

Wir kennen sie alle aus Science-fiction Filmen wie Star wars: Kampfroboter, Maschinen, die völlig eigenständig gegnerische Soldaten oder Roboter erkennen und bekämpfen können, meist noch in atemberaubender Geschwindigkeit und mit Fähigkeiten, die den menschlichen weit überlegen sind. Auch wenn an Modellen, die in diese Richtung gehen, in allen großen Militärmächten -USA, China, Russland – geforscht wird, sieht die aktuelle Situation doch noch ganz anders aus.

Dennoch sind auch heute schon Waffensysteme im Einsatz, die hochautomatisiert bzw. z.T. auch schon halbautonom sind: unbemannte Luftfahrzeuge, unmanned aerial vehicles (UAV) sind die bekanntesten von ihnen, landläufig eher als Drohnen bezeichnet, welche auch für zivile Zwecke zum Einsatz kommen, etwa in der Landwirtschaft. Analog gibt es natürlich auch unbemannte Landfahrzeuge, Schiffe und U-Boote.

Automatisierte Systeme kann man als solche Systeme verstehen, bei denen der Computer für jeweils eine spezifische Eingabe oder einen Sensorimpuls genau eine spezifische Reaktion generiert. Autonome Systeme hingegen versuchen Prozesse der kognitiven Psychologie beim Menschen nachzumodellieren (perception, cognition, action) und können damit bei bestimmten Informationen aufgrund der programmierten Algorithmen zu verschiedenen Reaktionen gelangen. Diese Nachbildung eines „Weltmodells“ benötigt also verschiedene Umgebungsdaten, die verarbeitet und aus denen dann Handlungsanweisungen für das System abgeleitet werden. Dies gelingt umso besser, je weniger beeinflussende Faktoren das System erkennen und analysieren muss. Aus diesem Grund sind Drohnen schon relativ weit in ihrer Autonomie vorangeschritten: diese orientieren sich primär an Landkarten, Höhenangaben und Flugverbotszonen. Mittels Radar können sie eventuelle Hindernisse auf der Flugbahn erfassen und über GPS ihre Position bestimmen. Andere Flugkörper emittieren zudem über ihre Transponder Signale, die von der Drohne bei ihrer Flugbahnberechnung ebenfalls erfasst werden können. Aufklärungsdrohnen können auf der Basis dieser Informationen selbständig starten, bestimmte Gebiete überfliegen, mit Sensoren abtasten und auch wieder landen. Autopilotsysteme in zivilen Flugzeugen operieren im Prinzip nach dem gleichen Muster, der Pilot im Cockpit kann hier aber jederzeit in das System manuell eingreifen.

Es liegt auf der Hand, dass z.B. die Probleme beim autonomen Fahren ungleich größer sind, da hier der Computer im Fahrzeug wesentlich mehr Einflussfaktoren möglichst fehlerfrei identifizieren können muss, um daraus ein unfallfreies Fahren des Autos ableiten zu können.

Die Autonomie endet im Moment noch dort, wo die Sensordatenverarbeitung nicht ausreicht, um eine Entscheidung für das System zu treffen, sondern (langjähriges) Erfahrungswissen erforderlich ist, vor allem in Situationen mit einem hohen Grad an Unsicherheit. Exemplarisch kann man hier die Landung eines Flugzeugs auf dem Hudson River im Jahr 2009 nach einem doppelten Triebwerksausfall nennen. Kein Autopilotsystem hätte in kürzester Zeit die Entscheidung zur Notwasserung fällen können, wie der Pilot sie vornahm. Nur langjährig erworbenes Erfahrungswissen erlaubte sowohl die schnelle Einschätzung der Situation als auch dann daraus die richtige Schlussfolgerung zu ziehen.

Im militärischen Kontext sind daher alle Entscheidungen, die mit einem hohen Grad an Unsicherheit behaftet sind und genaues Abwägen erfordern, nach wie vor dem Menschen überlassen. Der Befehl zum Abfeuern einer Rakete durch eine Kampfdrohne wird aus Kontrollzentren weit entfernt vom Ort des Geschehens gegeben. Fragen der Zuverlässigkeit der Informationen (wird das richtige Ziel getroffen), der Verhältnismäßigkeit und ethischen Vertretbarkeit (werden u.U. unbeteiligte Zivilisten mitgetroffen, euphemistisch oft als Kollateralschaden bezeichnet) müssen in kürzester Zeit entschieden werden. Die psychischen Anforderungen an die Drohnenpiloten ähneln denen von Flugzeugpiloten im Kampfeinsatz, vergleichbare Belastungsstörungen sind ebenfalls bekannt.

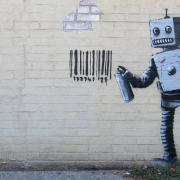

Der nächste Schritt in der Weiterentwicklung autonomer Militärroboter müsste diese befähigen, durch künstliche Intelligenz ohne Fernlenkung oder Vorprogrammierung eines festen Ablaufplans auf sich verändernde Situationen zu reagieren und in letzter Konsequenz auch den Einsatz von Waffen selbst auszulösen. Dieser gesamte Prozess müsste zudem so ablaufen, dass das System möglichst zweifelsfrei zwischen feindlichen und eigenen Kräften unterscheiden könnte und dass es eine Abwägung treffen könnte, ob Kollateralschäden in unvertretbarem Ausmaß zu erwarten oder gar zivile Opfer zu beklagen wären. Insgesamt eine komplexe Gesamtsituation mit einem hohen Maß an Unsicherheit. Der „Kaperung“ des Systems durch den militärischen Gegner müsste zudem wirksam vorgebeugt werden.

Abgesehen von diesen technischen Herausforderungen stellt sich aber auch die Frage, ob solch ein System überhaupt ethisch zu vertreten wäre und ob es nicht unlösbare rechtliche Probleme nach sich zöge. Schließlich wäre die Verantwortung für die Entscheidung über Leben und Tod an eine Maschine abgegeben worden, die man im Nachhinein kaum noch nach dem internationalen Kriegsvölkerrecht zur Verantwortung ziehen könnte. Es gibt daher nicht wenige Stimmen von Wissenschaftlern und Juristen, die die Entwicklung solcher autonomen Systeme grundsätzlich international ächten bzw. verbieten möchten.

Dennoch kann man davon ausgehen, dass zumindest die Forschung an solchen Systemen weiter vorangetrieben werden wird. Insbesondere bei asymmetrischen Konflikten, bei der Aufstandsbekämpfung (counter insurgency), im Häuserkampf (urban warfare) und der Terrorismusabwehr, bei denen verlustreiche und lang andauernde Einsätze in den militärentsendenden Nationen zunehmend hinterfragt werden, scheint die Möglichkeit, in Zukunft größere Anteile der eingesetzten Soldaten durch intelligente Maschinen ersetzen zu können, verlockend zu sein.

Vielleicht sollte man sich daher noch einmal die vom Science-Fiction-Autor Isaac Asimov schon 1942 exemplarisch formulierten drei Regeln der Robotik in Erinnerung rufen:

1. A robot may not injure a human being or, through inaction, allow a human being to come to harm.

2. A robot must obey the orders given it by human beings except where such orders would conflict with the First Law.

3. A robot must protect its own existence as long as such protection does not conflict with the First or Second Laws. [Asimov, Isaac (1950). „Runaround“. I, Robot (The Isaac Asimov Collection ed.). New York City: Doubleday. p. 40.]

Für autonome Militärroboter hätten diese Regeln keine Gültigkeit mehr.

Weiterführende Literatur:

- Amoroso, Daniele et al., Autonomy in Weapon Systems: The military application of artificial intelligence as a litmus test for Germany’s new foreign and security policy; Berlin, Heinrich Böll Foundation, [2018].

- Biermann, Kai; Wiegold, Thomas, Drohen: Chancen und Gefahren einer neuen Technik, Berlin, Ch. Links Verlag, 2015.

- Cummings, M.L., Artificial intelligence and the future of warfare, Research Paper, International Security Department and US and the Americas Programme, January 2017, Chatham House, The Royal Institute of International Affairs.

https://www.chathamhouse.org/sites/default/files/publications/research/2017-01-26-artificial-intelligence-future-warfare-cummings-final.pdf - Payne, Kenneth, Strategy, evolution and war: From apes to artificial intelligence, Washington, Georgetown University Press, 2018.

- Reisner, Markus, Robotic wars: Legitimatorische Grundlagen und Grenzen des Einsatzes von Military unmanned Systems in modernen Konfliktszenarien, Berlin, Carola Hartmann Miles-Verlag, 2018.

- Schwarz, Elke, Death machines: The ethics of violent technologies, Manchester, Manchester University Press, 2018.

Mit diesem Beitrag verabschieden wir uns aus dem Wissenschaftsjahr 2019 zur Künstlichen Intelligenz, wünschen Ihnen schöne Festtage und freuen uns auf ein Wiederlesen bei unseren Beiträgen im nächsten Jahr!

Copyright United States public domain, [U.S. Air Force photo by Paul Ridgeway ]

Copyright United States public domain, [U.S. Air Force photo by Paul Ridgeway ]

CC BY 2.0 ING Group

CC BY 2.0 ING Group

Public Domain

Public Domain © Scott Lynch/ Flickr - CC BY-SA 2.0

© Scott Lynch/ Flickr - CC BY-SA 2.0

Susanne Henschel

Susanne Henschel Wissenswerkstatt Schulung SBB-PK CC BY-NC-SA 3.0

Wissenswerkstatt Schulung SBB-PK CC BY-NC-SA 3.0

Ihr Kommentar

An Diskussion beteiligen?Hinterlassen Sie uns einen Kommentar!